h^2

hat ne Keule +1

Hallo zusammen.

Mein momentaner FreeBSD Homeserver ist etwas in die Tage gekommen und soll demnächst ersetzt werden. Der Server dient vor allem als Storage für lokalen Zugriff (NFS). Außerdem hostet er eine Nextcloud und ein paar andere kleinere Dienste in jails.

Storage

Die größte Änderung soll sein den 3x4TB SATA raid durch einen 4x4TB NVME raid zu ersetzen. Außerdem soll eine 10Gbit (RJ45) Netzwerkkarte hinein. In der Kombination sollen die Zugriffe von meinem Desktop (der auch über 10Gbit angeschlossen wird) deutlich schneller werden, zB das Browsen großer Fotosammlungen (Generieren von thumbnails). Außerdem sollen die Zugriffe aus dem Netzwerk nicht so stark mit der Nextcloud konkurrieren etc.

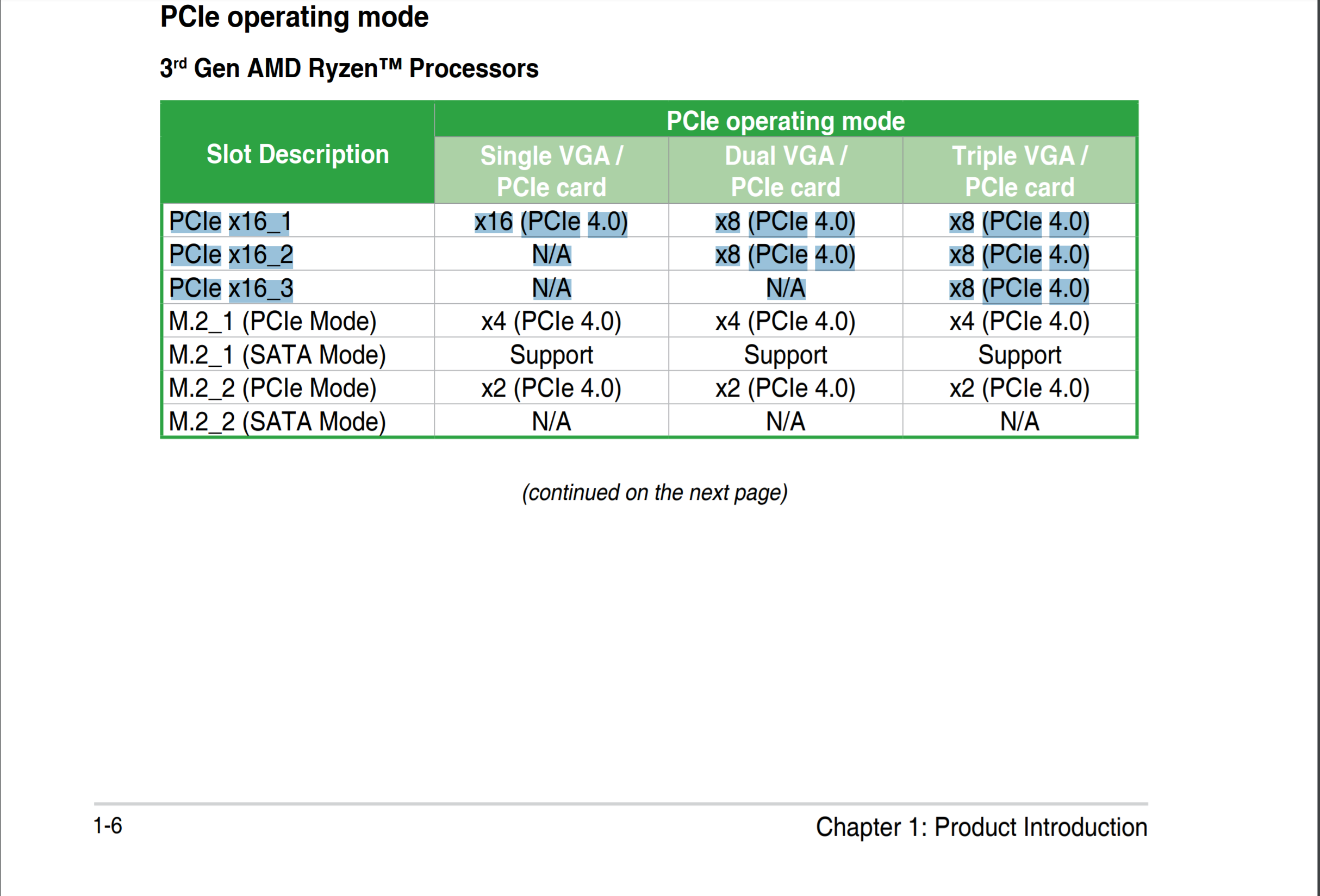

Zum Anschluss der vier NVMEs würde ich eine Adapterkarte wie dir hier nehmen:

Dann habe ich noch einen NVME auf dem Mainboard frei, falls ich später das RAID um eine NVME erweitern möchte.

Q1: Hat jemand Erfahrungen mit diesen Adapterkarten und NVME-Raids im Allgemeinen? Muss ich was bei der ZFS-Konfig beachten? Ein extra Log- oder Cache-Device brauche ich ja wahrscheinlich nicht mehr.

Netzwerk

Da die Mainboards mit integrierter 10Gbit-karte unverschämt teuer sind, dachte ich daran, zwei von den Intelkarten hier zu bestellen (einmal Server, einmal Desktop):

geizhals.de

geizhals.de

Habe dazu diesen Fred gefunden: https://forums.freebsd.org/threads/intel-x540-10-gbe-no-carrier-detected.88578/

Fazit: scheint jetzt zu gehen.

Mainboard und CPU

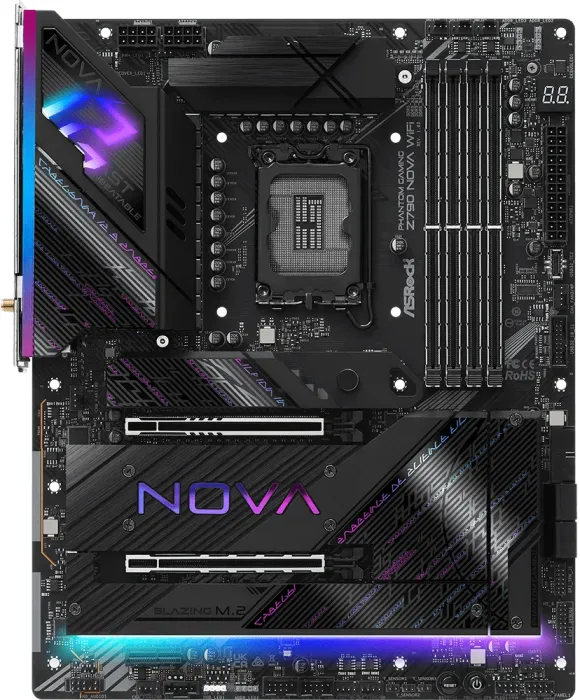

Hier bin ich mir noch ziemlich unsicher. Ich hätte gerne etwas, das möglichst wenig Strom verbraucht, aber eben auch genung PCI Steckplätze für o.g. Karten hat. Vielleicht irgendein AM4-Board und so eine CPU dazu: https://geizhals.de/amd-ryzen-5-pro-3350ge-yd335bc6m4mfh-a2413581.html ?

Das ist aber noch Zen+, also eine sehr alte Architektur. Warum gibt's von den neueren keine CPUs mit niedriger TDP, bzw. warum finde ich die nirgendwo (ich weiß dass es die gibt)?

Wäre hier über Empfehlungen sehr dankbar!

Gehäuse

Irgendein Server-Gehäuse, das normale ATX board nimmt. Ich habe noch genug Höhenheiten im Rack frei. Nice wäre ein Netzteil, das auch im niedrigen Wattbereich noch effizient ist. Auch hier bin ich gespannt auf eure Erfahrungswerte!

Hört sich das alles stimmig an?

Vielen Dank schonmal!

Mein momentaner FreeBSD Homeserver ist etwas in die Tage gekommen und soll demnächst ersetzt werden. Der Server dient vor allem als Storage für lokalen Zugriff (NFS). Außerdem hostet er eine Nextcloud und ein paar andere kleinere Dienste in jails.

Storage

Die größte Änderung soll sein den 3x4TB SATA raid durch einen 4x4TB NVME raid zu ersetzen. Außerdem soll eine 10Gbit (RJ45) Netzwerkkarte hinein. In der Kombination sollen die Zugriffe von meinem Desktop (der auch über 10Gbit angeschlossen wird) deutlich schneller werden, zB das Browsen großer Fotosammlungen (Generieren von thumbnails). Außerdem sollen die Zugriffe aus dem Netzwerk nicht so stark mit der Nextcloud konkurrieren etc.

Zum Anschluss der vier NVMEs würde ich eine Adapterkarte wie dir hier nehmen:

Dann habe ich noch einen NVME auf dem Mainboard frei, falls ich später das RAID um eine NVME erweitern möchte.

Q1: Hat jemand Erfahrungen mit diesen Adapterkarten und NVME-Raids im Allgemeinen? Muss ich was bei der ZFS-Konfig beachten? Ein extra Log- oder Cache-Device brauche ich ja wahrscheinlich nicht mehr.

Netzwerk

Da die Mainboards mit integrierter 10Gbit-karte unverschämt teuer sind, dachte ich daran, zwei von den Intelkarten hier zu bestellen (einmal Server, einmal Desktop):

Intel X540-T1 10G LAN-Adapter, RJ-45, PCIe 2.1 x8, retail ab € 72,99 (2024) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Intel X540-T1 10G LAN-Adapter, RJ-45, PCIe 2.1 x8, retail ✔ Produktinfo ⇒ Typ: LAN-Adapter • Bauform: 1x PCIe-Karte (wechselbare Blende: full height und low profile Blende im Lief… ✔ Adapter & Hubs ✔ Testberichte ✔ Günstig kaufen

Habe dazu diesen Fred gefunden: https://forums.freebsd.org/threads/intel-x540-10-gbe-no-carrier-detected.88578/

Fazit: scheint jetzt zu gehen.

Mainboard und CPU

Hier bin ich mir noch ziemlich unsicher. Ich hätte gerne etwas, das möglichst wenig Strom verbraucht, aber eben auch genung PCI Steckplätze für o.g. Karten hat. Vielleicht irgendein AM4-Board und so eine CPU dazu: https://geizhals.de/amd-ryzen-5-pro-3350ge-yd335bc6m4mfh-a2413581.html ?

Das ist aber noch Zen+, also eine sehr alte Architektur. Warum gibt's von den neueren keine CPUs mit niedriger TDP, bzw. warum finde ich die nirgendwo (ich weiß dass es die gibt)?

Wäre hier über Empfehlungen sehr dankbar!

Gehäuse

Irgendein Server-Gehäuse, das normale ATX board nimmt. Ich habe noch genug Höhenheiten im Rack frei. Nice wäre ein Netzteil, das auch im niedrigen Wattbereich noch effizient ist. Auch hier bin ich gespannt auf eure Erfahrungswerte!

Hört sich das alles stimmig an?

Vielen Dank schonmal!