pit234a

Well-Known Member

vfs.zfs.recover="1" in der /boot/loader.conf hat mir eben sehr geholfen.

Vorausgegangen ist ein unerklärlicher Crash einiger zpools, darunter auch mein ROOT-pool.

Wie das passiert ist, weiß ich gar nicht.

Wann das passierte schon etwas besser. Nämlich, nachdem ich, wie inzwischen ja gewohnt eher nebenbei einen freebsd-update von 13.1 auf 13.2 gemacht hatte. Die meisten Fehler passieren mir dabei dann, wenn ich nochmal beim Mergen Hand anlegen will, weil ich da unbedingt noch was verbessern möchte. An sowas habe ich mich also bereits gewöhnt und mache niemals einen Upgrade ohne einen aktuellen Snap zu erstellen (und natürlich vorher auch drei Backups meiner "working-Datas" zu haben). Soweit alles gut.

Nur läuft das normalerweise immer gleich: freebsd-update...install...Neustart..und...nochmal..install.

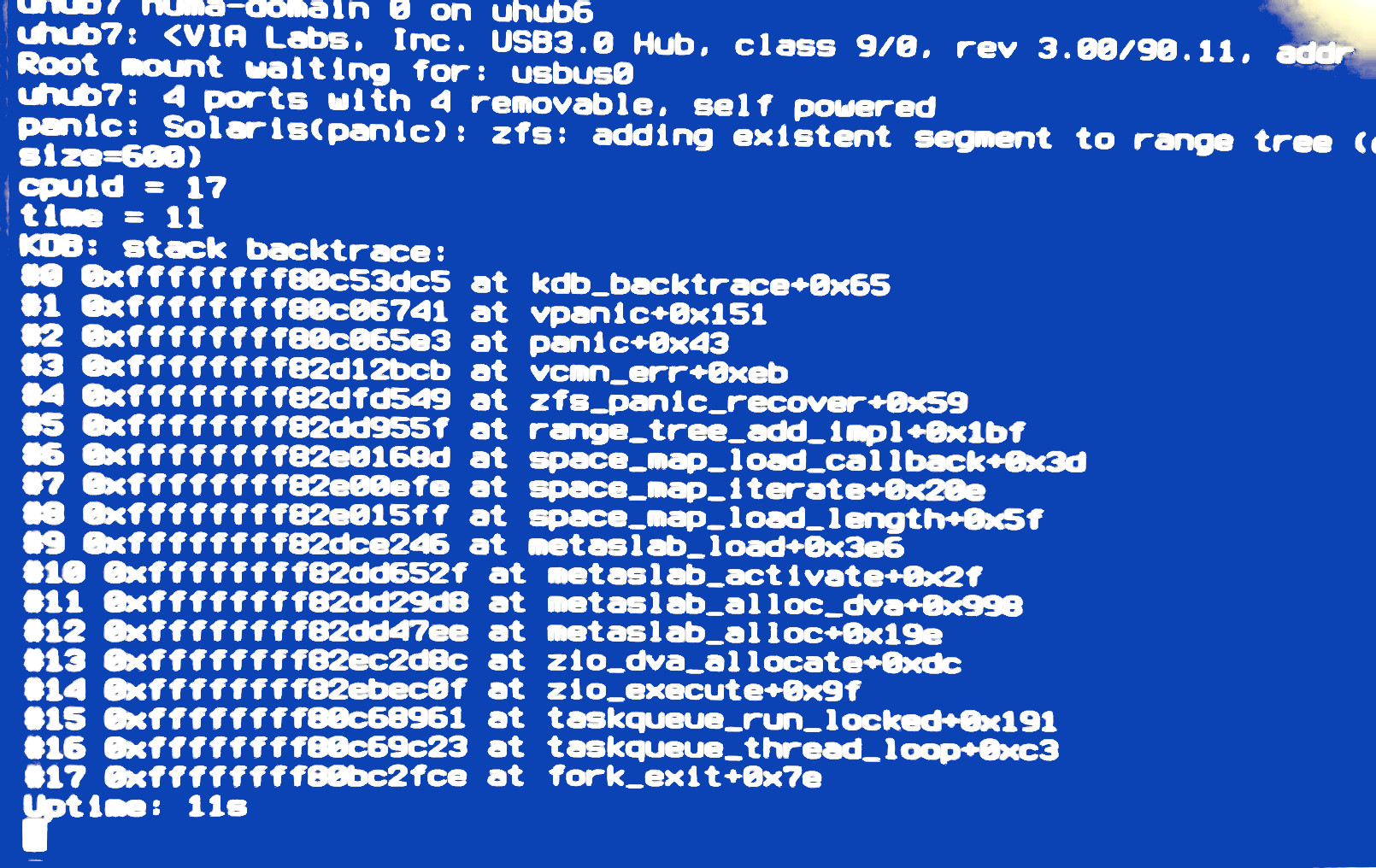

Diesmal war es mir zu spät und ich wählte nach dem ersten install ein shutdown, um dann am nächsten Morgen weiter zu machen. Auch das noch alles gut, nur wartete ich den shutdown nicht ab und hätte dann ja eh nichts machen können. Mein PC hat ja eine Macke und schaltet sich sehr unzuverlässig gelegentlich einfach aus. Vielleicht hat dies hier genau während shutdown gefunkt, denn am nächsten Morgen konnte ich den Rechner nicht mehr booten und erhielt eine Crash-Meldung, die so schnell verging, dass ich mit Handy ein unbeholfenes Video davon aufgenommen und davon dann ein Bild gemacht habe, an dem ich mich weiter orientierte:

Das gute Internet gab mir einige Vorschläge dazu und ich konnte tatsächlich meine korrupten Pools nur noch importieren, nachdem ich in meinem Notsystem mit vfs.zfs.recover="1" in der loader.conf gebootet hatte. Ansonsten gab es sofort den oben gezeigten Crash.

Ein mehrfaches scrub bereinigte die Pools, aber ich setzte trotzdem nun auch das vfs.zfs.recover="1" in meinen ROOT-Pool des aktiven Systems.

Dieses bootete dann anschließend und ich konnte meinen freebsd-update beenden und so weiter.

Nun habe ich dieses vfs.zfs.recover="1" noch immer in der loader.conf.

Ich glaube, dass ich es nun nicht mehr brauche, aber, wenn ich das schon so gehabt hätte, wäre mir womöglich ein wenig Arbeit erspart geblieben.

Deshalb hier die Frage, ob es Nachteile bringt, es in der loader.conf zu haben. Also quasi für den Fall der Fälle, der eigentlich nie passiert...

Vorausgegangen ist ein unerklärlicher Crash einiger zpools, darunter auch mein ROOT-pool.

Wie das passiert ist, weiß ich gar nicht.

Wann das passierte schon etwas besser. Nämlich, nachdem ich, wie inzwischen ja gewohnt eher nebenbei einen freebsd-update von 13.1 auf 13.2 gemacht hatte. Die meisten Fehler passieren mir dabei dann, wenn ich nochmal beim Mergen Hand anlegen will, weil ich da unbedingt noch was verbessern möchte. An sowas habe ich mich also bereits gewöhnt und mache niemals einen Upgrade ohne einen aktuellen Snap zu erstellen (und natürlich vorher auch drei Backups meiner "working-Datas" zu haben). Soweit alles gut.

Nur läuft das normalerweise immer gleich: freebsd-update...install...Neustart..und...nochmal..install.

Diesmal war es mir zu spät und ich wählte nach dem ersten install ein shutdown, um dann am nächsten Morgen weiter zu machen. Auch das noch alles gut, nur wartete ich den shutdown nicht ab und hätte dann ja eh nichts machen können. Mein PC hat ja eine Macke und schaltet sich sehr unzuverlässig gelegentlich einfach aus. Vielleicht hat dies hier genau während shutdown gefunkt, denn am nächsten Morgen konnte ich den Rechner nicht mehr booten und erhielt eine Crash-Meldung, die so schnell verging, dass ich mit Handy ein unbeholfenes Video davon aufgenommen und davon dann ein Bild gemacht habe, an dem ich mich weiter orientierte:

Das gute Internet gab mir einige Vorschläge dazu und ich konnte tatsächlich meine korrupten Pools nur noch importieren, nachdem ich in meinem Notsystem mit vfs.zfs.recover="1" in der loader.conf gebootet hatte. Ansonsten gab es sofort den oben gezeigten Crash.

Ein mehrfaches scrub bereinigte die Pools, aber ich setzte trotzdem nun auch das vfs.zfs.recover="1" in meinen ROOT-Pool des aktiven Systems.

Dieses bootete dann anschließend und ich konnte meinen freebsd-update beenden und so weiter.

Nun habe ich dieses vfs.zfs.recover="1" noch immer in der loader.conf.

Ich glaube, dass ich es nun nicht mehr brauche, aber, wenn ich das schon so gehabt hätte, wäre mir womöglich ein wenig Arbeit erspart geblieben.

Deshalb hier die Frage, ob es Nachteile bringt, es in der loader.conf zu haben. Also quasi für den Fall der Fälle, der eigentlich nie passiert...