Guten Tag,

ich hoffe, ich finde hier - als ZFS-Laie - die Lösung meines Problems:

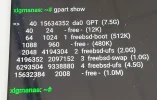

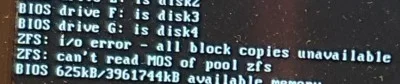

Ich nutze die aktuelle Version von XigmaNAS auf einem HP Microserver Gen8. Es sind 2 Pools (1 x RaidZ1 und 1 x Stripe) eingerichtet. Nach dem letzten Update (möglicherwiese auch schon früher) ist mir aufgefallen, dass es beim Booten zu folgenden Fehlermeldung kommt:

I/O error - all block copies unavailable - can't read MOS pool home

Für den 2. Pool erscheint die selbe Fehlermeldung.

Das System lief zuvor problemlos auf einer SSD als RootOnZFS-System. Der Wechsel auf die "embedded"-Version mit Booten von einem USB-Stick brachte auch keine Änderung. Was mich wundert ist, dass die Fehlermeldung auch erscheint, wenn ich von einem frischen Live-USB-Stick boote.

Ich gehe davon aus, dass der fehlerhafte Bootcode auf den Platten der Pools gespeichert ist.

Beide Pools sind allerdings fehlerfrei "online" und "zpool status" zeigt keinerlei Fehler.

Ich hatte in einem anderen Thread hier gelesen, dass man mit

gpart bootcode -b /boot/pmbr -p /boot/gptzfsboot -i 1 da0

den Bootcode neu schreiben soll.

Bei mir wären das die Platten ada0 bis ada4. Leider scheitert dies mit der Fehlermeldung "invalid arguments".

Nun bin ich natürlich mit meinem Latein am Ende

Wie lautet denn der "richtige" Befehl, um den Bootcode auf den Platten neu zu schreiben?? Und was genau bedeutet eigentlich die Fehlermeldung?? Sind die Daten in den Pools in Gefahr??

Fragen über Fragen .....

defcon999

ich hoffe, ich finde hier - als ZFS-Laie - die Lösung meines Problems:

Ich nutze die aktuelle Version von XigmaNAS auf einem HP Microserver Gen8. Es sind 2 Pools (1 x RaidZ1 und 1 x Stripe) eingerichtet. Nach dem letzten Update (möglicherwiese auch schon früher) ist mir aufgefallen, dass es beim Booten zu folgenden Fehlermeldung kommt:

I/O error - all block copies unavailable - can't read MOS pool home

Für den 2. Pool erscheint die selbe Fehlermeldung.

Das System lief zuvor problemlos auf einer SSD als RootOnZFS-System. Der Wechsel auf die "embedded"-Version mit Booten von einem USB-Stick brachte auch keine Änderung. Was mich wundert ist, dass die Fehlermeldung auch erscheint, wenn ich von einem frischen Live-USB-Stick boote.

Ich gehe davon aus, dass der fehlerhafte Bootcode auf den Platten der Pools gespeichert ist.

Beide Pools sind allerdings fehlerfrei "online" und "zpool status" zeigt keinerlei Fehler.

Ich hatte in einem anderen Thread hier gelesen, dass man mit

gpart bootcode -b /boot/pmbr -p /boot/gptzfsboot -i 1 da0

den Bootcode neu schreiben soll.

Bei mir wären das die Platten ada0 bis ada4. Leider scheitert dies mit der Fehlermeldung "invalid arguments".

Nun bin ich natürlich mit meinem Latein am Ende

Wie lautet denn der "richtige" Befehl, um den Bootcode auf den Platten neu zu schreiben?? Und was genau bedeutet eigentlich die Fehlermeldung?? Sind die Daten in den Pools in Gefahr??

Fragen über Fragen .....

defcon999

... und berichten! Backups sind vorhanden.

... und berichten! Backups sind vorhanden.

... als ZFS-Dummie kannte ich diesen Befehl nicht

... als ZFS-Dummie kannte ich diesen Befehl nicht